AI预测神经学研究结论超越人类专家 科研党狂喜

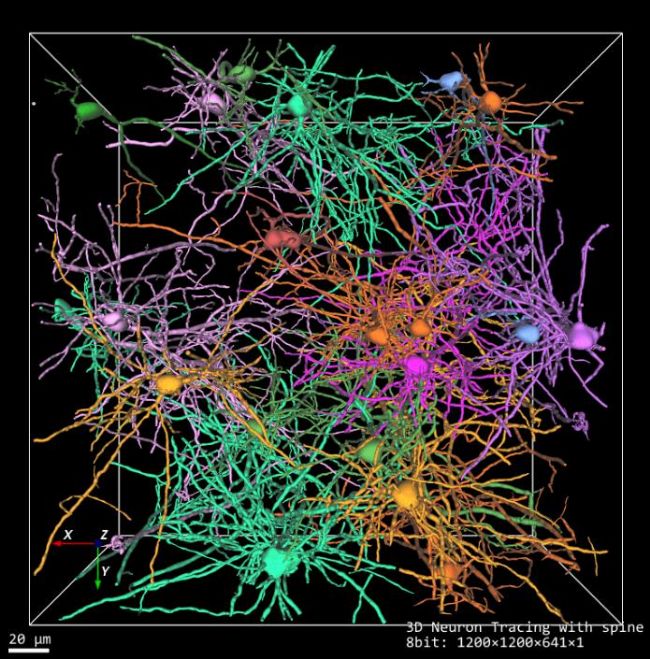

最近,来自伦敦大学学院、剑桥大学、牛津大学等机构的团队发布了一个神经学专用基准BrainBench,登上了《Nature》子刊《自然人类行为(Nature human behavior)》。结果显示,经过该基准训练的LLM在预测神经科学结果的准确度方面高达81.4%,远超人类专家的63%。

在神经学常见的5个子领域:行为/认知、细胞/分子、系统/回路、神经疾病的神经生物学以及发育/塑性和修复中,LLM的表现也都全方位超过了人类专家。

更重要的是,这些模型被证实对于数据没有明显的记忆。也就是说,它们已经掌握了一般科研的普遍模式,可以做更多的前瞻性预测、预测未知的事物。

这立马引发科研圈的围观。多位教授和博士后博士后也表示,以后就可以让LLM帮忙判断更多研究的可行性了,nice!

LLM预测能力全面超越人类专家

让我们先来看看本文的几个重要结论:

- 总体结果:LLMs在BrainBench上的平均准确率为81.4%,而人类专家的平均准确率63.4%。LLMs的表现显著优于人类专家

- 子领域表现:在神经科学的几个重要的子领域:行为/认知、细胞/分子、系统/回路、神经疾病的神经生物学以及发育/塑性和修复中,LLMs在每个子领域的表现均优于人类专家,特别是在行为认知和系统/回路领域。

- 模型对比:较小的模型如Llama2-7B和Mistral-7B与较大的模型表现相当,而聊天或指令优化模型的表现不如其基础模型。

评估LLM是否纯记忆

为了衡量LLM是否掌握了思维逻辑,团队还使用zlib压缩率和困惑度比率来评估LLMs是否记忆了训练数据。

公式如下:

``` Memory Score = ZLIB(X) / PPL(X) ```其中,ZLIB(X)表示文本X的zlib压缩率,PPL(X)表示文本X的困惑度。

如果LLM只是记忆了训练数据,那么它在压缩后的文本上的困惑度应该很低。但是,研究发现LLMs在压缩后的文本上的困惑度与在原始文本上的困惑度相当,这表明它们学习的是广泛的科学模式,而不是记忆训练数据。

部分研究者认为只能当作辅助

本文向我们展示了神经科学研究的一个新方向,或许未来在前期探索的时候,神经学专家都可以借助LLM的力量进行初步的科研想法筛选,剔除一些在方法、背景信息等方面存在明显问题的计划等。

但同时也有很多研究者对LLM的这个用法表示了质疑。有人认为实验才是科研最重要的部分,任何预测都没什么必要:

预测东西有什么用?真正重要的是实验。

还有研究者认

相关标签: 人类、 结果、 专家、 狂喜、 结论、 预测、 Nature、 研究、 人类、 模型、 水平、 神经学、 困惑度、 zlib、 神经、

本文地址:http://dy.qianwe.com/article/1301.html

<a href="http://dy.qianwe.com/" target="_blank">前卫目录网</a>

人气排行榜

人气排行榜

豫公网安备 41172402000154号

豫公网安备 41172402000154号