AI突破神经学研究界限 预测结论精度超越专家团队

奇月发自凹非寺量子位 | 公众号 QbitAI

LLM 可以比科学家更准确地预测神经学的研究结果!

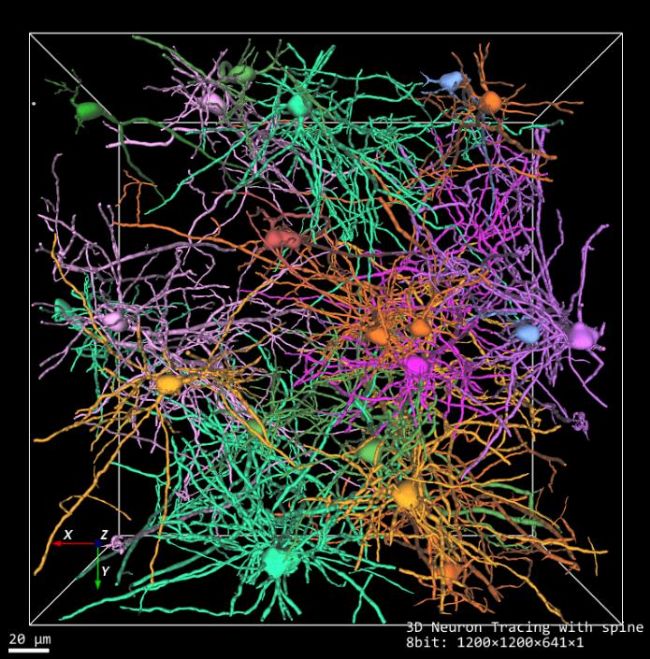

最近,来自伦敦大学学院、剑桥大学、牛津大学等机构的团队发布了一个神经学专用基准 BrainBench,登上了 Nature 子刊《自然人类行为(Nature human behavior)》。结果显示,经过该基准训练的 LLM 在预测神经科学结果的准确度方面高达 81.4%,远超人类专家的 63%。

在神经学常见的 5 个子领域:行为/认知、细胞/分子、系统/回路、神经疾病的神经生物学以及发育/塑性和修复中,LLM 的表现也都全方位超过了人类专家。

更重要的是,这些模型被证实对于数据没有明显的记忆。也就是说,它们已经掌握了一般科研的普遍模式,可以做更多的前瞻性(Forward-looking)预测、预测未知的事物。

这立马引发科研圈的围观。多位教授和博士后博士后也表示,以后就可以让 LLM 帮忙判断更多研究的可行性了,nice!

LLM 预测能力全面超越人类专家

让我们先来看看本文的几个重要结论:

- 总体结果:LLM 在 BrainBench 上的平均准确率为 81.4%,而人类专家的平均准确率 63.4%。

- LLM 的表现显著优于人类专家

- 子领域表现:在神经科学的几个重要的子领域:行为/认知、细胞/分子、系统/回路、神经疾病的神经生物学以及发育/塑性和修复中,LLM 在每个子领域的表现均优于人类专家,特别是在行为认知和系统/回路领域。

- 模型对比:较小的模型如 LLama2-7B 和 Mistral-7B 与较大的模型表现相当,而聊天或指令优化模型的表现不如其基础模型。

- 人类专家的表现:大多数人类专家是博士学生、博士后研究员或教职员工。当限制人类响应为自我报告专业知识的最高 20% 时,准确率上升到 66.2%,但仍低于 LLMS。

- 置信度校准:LLM 和人类专家的置信度都校准良好,高置信度的预测更有可能是正确的。

- 记忆评估:没有迹象表明 LLM 记忆了 BrainBench 项目。使用 zlib 压缩率和困惑度比率的分析表明,LLM 学习的是广泛的科学模式,而不是记忆训练数据。

全新神经学基准

本本文的一个重要贡献,就是提出了一个前瞻性的基准测试 BrainBench,可以专门用于评估 LLM 在预测神经科学结果方面的能力。

那么,具体是怎么做到的呢?

数据收集

团队从 PubMed 和其他数据库中收集了 300 篇神经科学本文。然后他们将这些本文中的关键部分(如摘要、介绍、讨论)提取成文本。

评估 LLM 和人类专家

在上面收集的数据的基础上,团队为 BrainBench 创建了测试用例,主要通过修改本文摘要来实现。每个测试用例包括两个版本的摘要:一个是原始版本,另一个是经过修改的版本。修改后的摘要会显著改变研究结果,但保持整体连贯性。

测试者的任务是选择哪个版本包含实际的研究结果。

团队使用 EleutherAI Language Model Evaluation Harness 框架,让 LLM 在两个版本的摘要之间进行选择,通过困惑度(perplexity)来衡量其偏好。困惑度越低,表示模型越喜欢该摘要。

对人类专家行为的评估也是在相同测试用例上进行选择,他们还需要提供自信度和专业知识评分。最终参与实验的神经新的可能性。未来,LLM 有望成为神经科学研究中的强大工具,帮助我们更好地理解大脑和神经系统。

相关标签: 结论、 模型、 预测、 神经学、 人类、 水平、 结果、 专家、 困惑度、 人类、 神经、 狂喜、 zlib、 研究、 Nature、

本文地址:http://dy.qianwe.com/article/2290.html

<a href="http://dy.qianwe.com/" target="_blank">前卫目录网</a>

人气排行榜

人气排行榜

豫公网安备 41172402000154号

豫公网安备 41172402000154号